MICROSOFT ESTÁ DESARROLLANDO UN GENERADOR DE RAP AI, MÁS PROFUNDO, ENTRENADO EN UN GRAN CONJUNTO DE CANCIONES 'ARRASTRE' DE LA WEB

La música AI se está apoderando de la tecnología más importante.

Google puso a disposición del público MusicLM, un modelo de lenguaje que puede generar nueva música a partir de indicaciones de texto, el mes pasado.

Meta, la empresa matriz de Facebook, presentó MusicGen, su propio generador de IA de texto a música. La compañía afirma que MusicGen ha sido entrenado en 20 000 horas de música con licencia, incluidas 390 000 pistas de solo instrumentos de ShutterStock y Pond5 y 10 000 pistas de "alta calidad".

Sin embargo, los gigantes de la industria de la tecnología y la informática, como Meta y Google, no son los únicos que investigan la música con IA.

Microsoft, un rival, ejecuta un gran proyecto de investigación de AI Music. Los investigadores del proyecto están involucrados en una variedad de campos, incluida la composición de canciones, la generación de letras, la generación de letras a melodías, la generación de texto impulsada por IA y la generación de música.

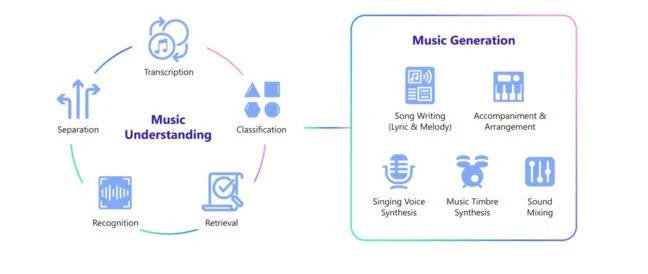

"Muzic" es un "proyecto sobre música de IA que potencia la comprensión y generación de música con aprendizaje profundo e inteligencia artificial", según Microsoft.

El diagrama de su página de inicio se puede ver a continuación:

Uno de los proyectos del "Grupo de aprendizaje profundo y reforzado" de Microsoft Research Asia (MSR Asia) en China es Muzic, que se estableció en 2019.

Con oficinas en Beijing y Shanghai, Microsoft Research Asia se describe como "un laboratorio de investigación de clase mundial". MSR Asia, que se fundó en 1998, "realiza investigaciones básicas y aplicadas en áreas centrales para la estrategia a largo plazo y la visión informática futura de Microsoft", según el gigante tecnológico.

El "Grupo de aprendizaje profundo y de refuerzo" está trabajando en proyectos relacionados con modelos de texto a voz basados en redes neuronales, traducción automática neuronal y más, además de su investigación de AI Music.

Para reiterar, "Muzic" ya ha producido una cantidad sustancial de trabajo relacionado con AI Music.

Algunos de sus proyectos más destacados incluyen:

1) DEEPRAPPER De todos los proyectos actualmente en desarrollo en Muzic, este puede hacer que algunos titulares de derechos musicales se queden boquiabiertos.

En 2021, los científicos de Muzic fomentaron un 'generador de rap' impulsado por inteligencia simulada llamado DeepRapper.

“Según el conocimiento de los investigadores, DeepRapper es el primer sistema [IA] que genera rap con rimas y ritmos”, es la afirmación que se hace en el documento que describe el desarrollo y las pruebas del modelo.

Continúan: Los raps creativos y de alta calidad de DeepRapper se demuestran mediante evaluaciones objetivas y subjetivas. El código de DeepRapper está disponible en GitHub y puede encontrarlo aquí.

Lo siguiente es del periódico: Las letras que riman fueron el foco de los trabajos anteriores para la generación del rap, pero los ritmos rítmicos, que son cruciales para la interpretación del rap, no lo fueron. En este documento, fomentamos DeepRapper, un marco de la era del rap basado en Transformer que puede mostrar las dos rimas y ritmos".

Según los investigadores, se desarrolló "un canal de extracción de datos para recopilar un conjunto de datos de rap a gran escala, que incluye una gran cantidad de canciones de rap con letras alineadas y ritmos rítmicos" para construir el sistema DeepRapper "ya que no hay un conjunto de datos de rap disponible con latidos rítmicos".

En segundo lugar, desarrollaron un modelo de rimas y ritmos de "modelos cuidadosos" conocido como "modelo de lenguaje autorregresivo basado en transformadores".

"PRIMERO RASTREAMOS UNA GRAN CANTIDAD DE CANCIONES DE RAP CON LETRAS Y AUDIOS DE CANTO DESDE LA WEB PARA MINAR UN CONJUNTO DE DATOS DE RAP A GRAN ESCALA".

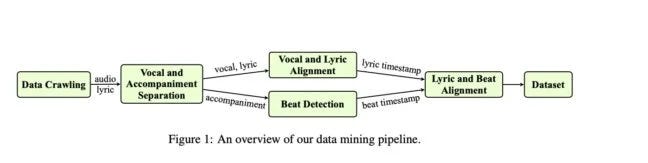

"una canalización de minería de datos [para] recopilar un conjunto de datos de rap a gran escala para el modelado de ritmo" se describe con mayor detalle más adelante en el documento (consulte el diagrama a continuación).

Elaboran: primero rastreamos una gran cantidad de canciones de rap con letras y audios de canciones de la Web antes de extraer un gran conjunto de datos de rap.

También rastreamos los tiempos de inicio y finalización de cada oración de la letra que corresponde al audio "para garantizar que la letra y el audio puedan alinearse en el nivel de la oración, lo que es beneficioso para nuestra alineación posterior del ritmo a nivel de palabra".

El equipo de investigación fue más allá con su extracción de datos. El trabajo de investigación dice que también usaron su "tubería de minería de datos" para obtener dos conjuntos de datos más: 1) canciones que no son de rap con ritmos alineados, que pueden tener un conjunto de datos más grande que las canciones de rap debido a su mayor generalidad; 2) letras puras, que pueden ser incluso más extensas que en canciones que no son rap.

Durante la "etapa previa al entrenamiento", el modelo DeepRapper se entrenó en los dos conjuntos de datos antes mencionados. Después de eso, "afinan nuestro modelo pre-entrenado en las canciones de rap con ritmos alineados", como lo explican.

"Tanto las evaluaciones objetivas como las subjetivas demuestran que DeepRapper genera raps de alta calidad con buenas rimas y ritmos", concluyen los investigadores.

Escogieron 5000 muestras al azar, algunas de las cuales puedes ver aquí.

Las muestras se crearon en mandarín y los investigadores proporcionaron las traducciones al inglés a través de Google Translate.

(¿La primera letra de las muestras que se han mostrado?) Deje que esta canción calme su insomnio médico ya que tenemos la piel amarilla y la sangre caliente.

“Gracias al diseño de DeepRapper, podemos construir aún más otro sistema de canto de rap para cantar los raps de acuerdo con las rimas y los ritmos, que dejamos como trabajo futuro”, es la conclusión del artículo.

Ahora se sabe bastante bien que los modelos de IA generativa se entrenan en grandes conjuntos de datos que se descargan con frecuencia de Internet.

Debido a la posibilidad de que estos modelos de IA de música con derechos de autor infrinjan sus derechos, este es un hecho que los titulares de derechos musicales no disfrutan particularmente. La sincera explicación del equipo de Microsoft sobre cómo se obtienen los datos de DeepRapper, aunque con fines de investigación, es interesante.

Es interesante notar que el estudio de rimas y rap de Microsoft parece ser global.

Microsoft tiene una patente de EE. UU. para un "bot de chat de rimas participativas sintetizadas por voz", que parece ser una herramienta completamente separada del modelo DeepRapper que fue desarrollado por el equipo de Muzic en China.

Otro grupo de investigadores de Microsoft con sede en los Estados Unidos ideó el concepto de esta tecnología "rap-bot". En abril de 2021, se le otorgó la patente.

El chatbot podría "apoyar batallas de rap" y "participar en el proceso de creación de música de una manera social", según el archivo obtenido por MBW.

La patente completa se puede leer aquí.

3) MUSECOCO El más reciente de estos proyectos es un generador de música de texto a símbolo impulsado por IA, cuyos detalles se dieron a conocer recién el 31 de mayo.

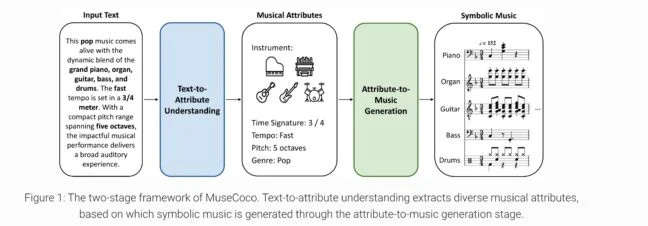

La "música simbólica" (por ejemplo, formato MIDI, pero no audio) se crea a partir de indicaciones de texto de "MuseCoCo", que significa "Copiloto de composición musical" (ver más abajo).

Según los investigadores, exportaron archivos mp3 de cómo suena la música como referencia utilizando la plataforma de notación MuseScore.

Han incluido comparaciones de otros modelos de lenguaje y una serie de muestras que muestran el audio producido al ingresar indicaciones de texto de diferentes longitudes y niveles de complejidad en la herramienta de composición.

Según Muzic de Microsoft, el modelo "permite a los músicos generar música directamente a partir de descripciones de texto dadas, ofreciendo una mejora significativa en la eficiencia en comparación con la creación de música completamente desde cero".

Junto con los resultados de la investigación, también se ha puesto a disposición del público un artículo que aún se está revisando.

Los investigadores dicen que su método para convertir texto en música "divide la tarea en dos etapas". La primera etapa se llama "comprensión de texto a atributo" y la segunda etapa se llama "generación de atributo a música".

El texto es "sintetizado y refinado" por ChatGPT durante la fase de "comprensión de texto a atributo".

Según el documento, MuseCoco "puede admitir múltiples formas de controlar" los resultados "debido al diseño de dos etapas".

Aclara: por ejemplo, los usuarios sin experiencia musical pueden confiar en el modelo de la primera etapa para convertir sus descripciones textuales intuitivas en atributos profesionales, mientras que los músicos con un gran conocimiento de la música pueden ingresar directamente los valores de los atributos en la segunda etapa para generar composiciones.

"Por lo tanto", afirma Muzic, "MuseCoco permite una experiencia de usuario que es más inclusiva y adaptable que los sistemas que generan música directamente a partir de descripciones de texto".

El modo en el que se entrenó también se describe en el documento. Tenga en cuenta que se utilizaron 20 000 horas de música con licencia para entrenar el modelo MusicGen AI de Meta, que puede generar clips de audio de 12 segundos a partir de un mensaje de texto.

Según los científicos de Muzic, "para preparar la etapa característica de la era de la música y evaluar nuestra técnica propuesta", reunieron una combinación de conjuntos de datos MIDI de "fuentes en línea".

Afirmaron que se quedaron con 947,659 muestras MIDI después de "hacer el filtrado de datos necesario para eliminar muestras duplicadas y de baja calidad".

El conjunto de datos MetaMIDI (MMD), que se describe como "una colección a gran escala de 436.631 archivos y metadatos MIDI", es uno de esos conjuntos de datos.

A través de un proceso de raspado web, el MMD "contiene metadatos de artistas y títulos para 221 504 archivos MIDI y metadatos de género para 143 868 archivos MIDI".